Dünyayı Bekleyen Tehlike, DEEPFAKE!

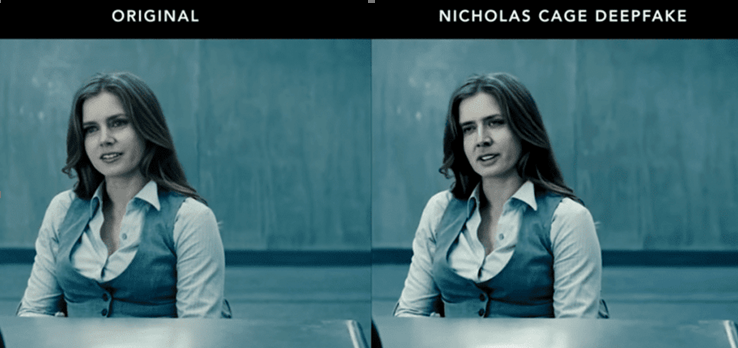

Yapay zekaya dayanan yapay görüntü sentezi tekniği Deepfake, sahte içerikler oluşturmak için hızlıca gelişmektedir. Hao Li, önümüzdeki 6 aylık bir süreçten sonra bu teknik ile oluşturulan sahte videoların tamamen tespit edilemeyeceğine belirtmektedir. Deepfake, çeşitli şekillerde uygulanabilen, bir insanın yüzünün başka bir insanın yüzü ile değiştirilmesinden, bir insanın sesini taklit eden sahte bir ses oluşturmaya kadar gelişen tekniktir.

|

|---|

| Şekil 1 : DeepFake Tekniği ile Oluşan Görüntü |

Deepfake tekniği, çoğunlukla iki makine öğrenmesi modelinden oluşan üretken ters ağlar (Generative Adversarial Networks - GAN) adı verilen bir teknolojiyi kullanmaktadır. GAN’daki bir model, sahte video görüntülerini oluşturmak için bir veri setinden yararlanırken, diğer model sahte görüntüleri algılamaya çalışmaktadır. İki model, biri diğerini tespit edinceye kadar birlikte çalışır. GAN teknolojisi, ilk olarak 2014 yılında Lan Goodfellow ve Montreal Üniversitesindeki araştırmacılar tarafından yayınlandı. Amaç, bilim endüstrisindeki astronomik görüntüleri geliştirmesini veya video oyunu geliştiricilerin oyunlarının kalitesini yükseltmelerini sağlamaktır.

|

|---|

| Şekil 2 : DeepFake Tekniği ile Oluşan Video Görüntüsü |

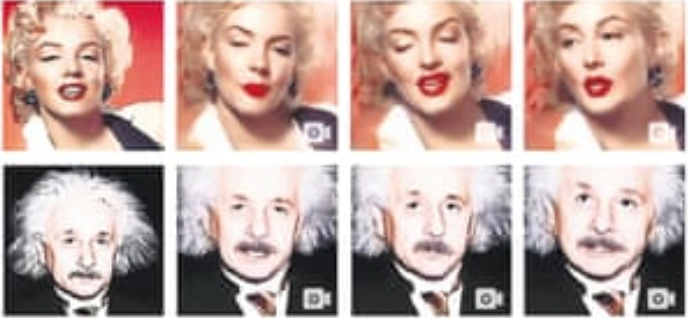

Video manipülasyonu yıllardır olmasına rağmen, GAN teknolojisi için kullanılan makine öğrenmesi ve yapay zeka araçları yeni bir gerçeklik seviyesini getirmiştir. Örnek olarak, 2018 yılında ortaya çıkan FaceApp uygulaması, yüzlerin sentezlenmesi için yüzlerce görüntünün kullanılmasına ihtiyaç duymaktadır. Ayrıca, App Zao gibi uygulamalar deepfake tekniği ile yüz takası gibi işlemler gerçekleştirmek için görüntüleri kullanması gerekmektedir.

Deepfake, toplumun güvenlik sorunlarıyla karşı karşıya kalmasına neden olabilir. Kötü niyetli saldırgan, oltalama (phishing) saldırıları, dolandırıcılık, kişisel bilgilerinin çalınması, itibar kaybına sebep olmak, kişi ile ilgili pornografik görüntülerin hazırlanıp yayılması gibi birçok kötü niyetli eylemler gerçekleştirebilir.

Birinin imajını ve davranışını taklit etme yeteneği ile saldırgan, kurbanın ailesini dolandırarak aile üyelerinin kişisel bilgilerini hatta finansal açıdan kazanç elde edebilir. Ya da herhangi bir devlet görevlisini taklit ederek yüksek güvenlikli alanlara giriş yapmak için kullanabilir. Bu teknoloji ve teknik Red Teaming çalışmalarında kullanılabilir. Örnek olarak, bir kuruluşun CEO’su gibi konuşan sahte sesleri kullanarak kuruluşun finans sorumlusunda kritik bilgiler elde edilebilir. Ayrıca herhangi bir insanın pornografik görüntüleri hazırlanarak, tehdit şantaj ve itibar kaybına sebep olacak saldırılar olabilir. Örnek olarak Discord, belirli kişiler tarafından kurulan bir grupta ünlülerin görüntüleri üzerinde pornografik görüntülerin oluşturulup grupta paylaşıldığını tespit edince grubu kapatmıştır.

|

|---|

| Şekil 3 : DeepFake Tekniği ile Oluşan Görüntü |

Teknoloji endüstrisi, bir bütün olarak deepfake tekniğinin algılanması için yatırımlar yapmaya başlamıştır. Deepfake ses kliplerin görsel sunumlarını kullanan, konuşma sentezini modellerini eğitmek için kullanılan derin sinir ağı olan seslerin derinliği için geliştirilen açık kaynaklı RealTalk uygulaması piyasaya sürüldü. Ayrıca sahte video görüntüleri ve ses kayıtları ile ilgili araştırma yapan araştırmacılara Facebook, Microsoft ve Google gibi büyük şirketler sponsor olmaktadır.